A arquitetura Transformer mudou o processamento de sequências ao introduzir o attention, mas seu custo cresce drasticamente com o tamanho da sequência, limitando o uso em contextos muito longos. Para superar isso, surgiram alternativas como RNNs eficientes e modelos de espaço de estados (SSMs), que são rápidos, porém comprimem demais a informação, perdendo detalhes importantes.

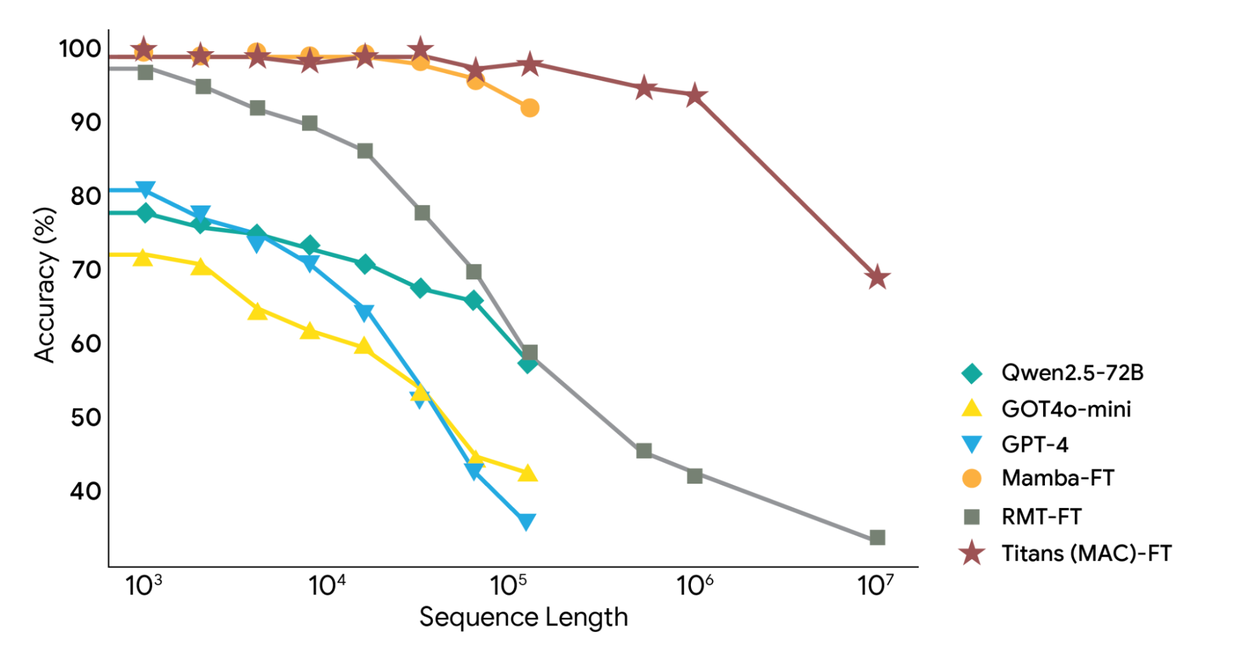

Os novos trabalhos Titans e MIRAS propõem uma solução combinando a velocidade das RNNs com a precisão dos Transformers. Titans é a arquitetura prática, enquanto MIRAS é o modelo teórico por trás dela. Juntos, eles permitem memorização em tempo de execução, mantendo memória de longo prazo sem precisar de re-treinamento offline.

Diferente de modelos que condensam tudo em um estado fixo, MIRAS e Titans conseguem atualizar a memória enquanto o modelo está rodando, incorporando novos dados imediatamente. Titans usa módulos separados para memória de curto e de longo prazo — como o cérebro humano. A longo prazo, em vez de uma memória fixa, usa uma rede neural profunda mais expressiva, capaz de reter grandes quantidades de informação sem perder contexto.

Um ponto-chave é o surprise metric: o modelo prioriza e lembra melhor informações inesperadas ou importantes — similar à forma como humanos gravam eventos marcantes e esquecem os triviais.

Visão geral da arquitetura Titans (MAC):

Ela utiliza uma memória de longo prazo para compactar os dados anteriores e incorporar esse resumo ao contexto, repassando-o ao mecanismo de attention. O attention então decide se precisa ou não consultar o resumo do passado.

No Titans, o surprise metric é o modo como o modelo detecta a diferença entre o que já lembra e o que o novo dado está informando.

• Baixa surpresa: se o modelo já espera algo relacionado e recebe a palavra “cat”, não há motivo para gravar isso de forma permanente.

• Alta surpresa: se o modelo está resumindo um relatório financeiro e recebe, de repente, uma imagem de uma casca de banana, isso é inesperado. O gradiente sobe e indica: “isso é importante, memorize!”

Esse sinal interno funciona como uma forma matemática de dizer ao modelo quando algo é realmente novo ou relevante.

Titans aprimora o mecanismo com dois pontos-chave:

Momentum: avalia não só a surpresa do momento, mas também a recente — garantindo que informações relacionadas depois de um evento inesperado também sejam preservadas.

Esquecimento (weight decay): como a memória tem capacidade limitada, o modelo elimina dados antigos ou pouco úteis ao longo do tempo, mantendo tudo leve e eficiente.

| Paper | Link |

|---|---|

| Mira | https://arxiv.org/pdf/2504.13173 |

| Titan | https://arxiv.org/abs/2501.00663 |

Seja Membro Gratuítamente

Assine a newsletter para receber em seu email as publicações atualizadas neste blog